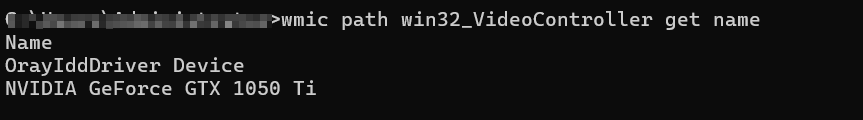

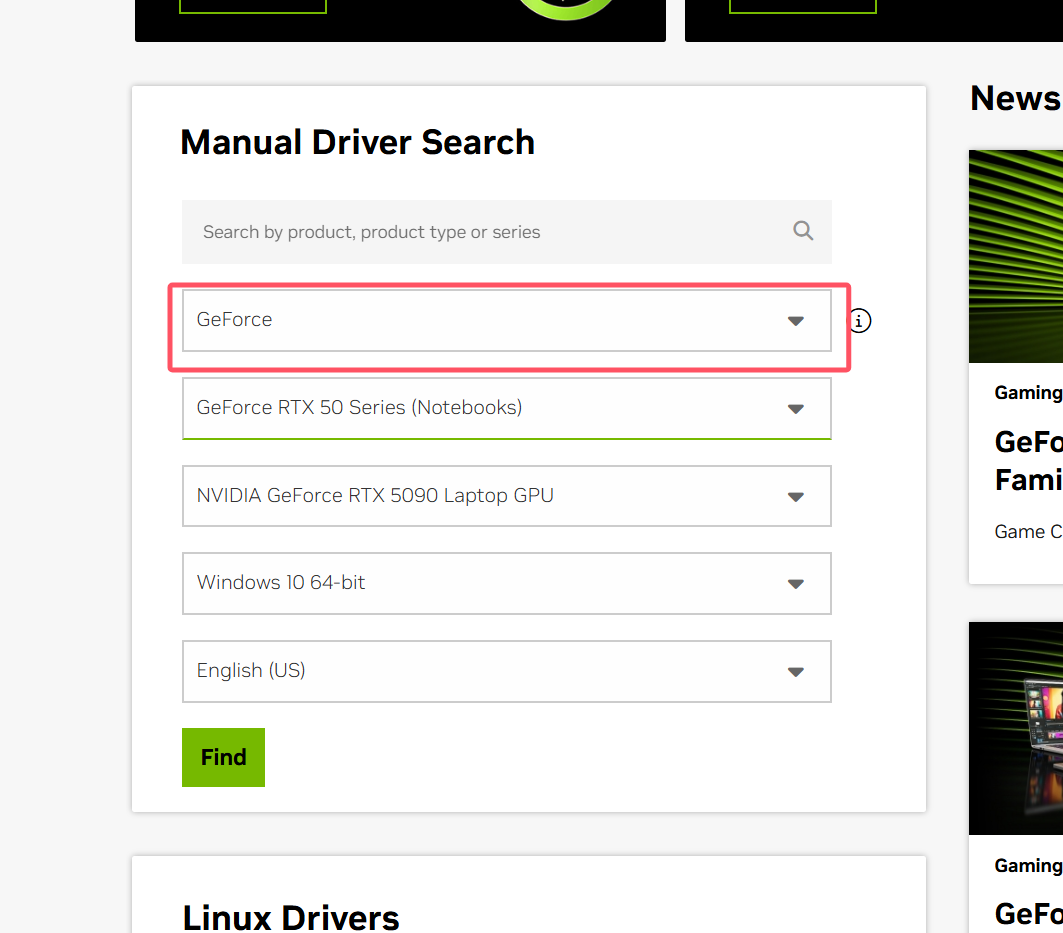

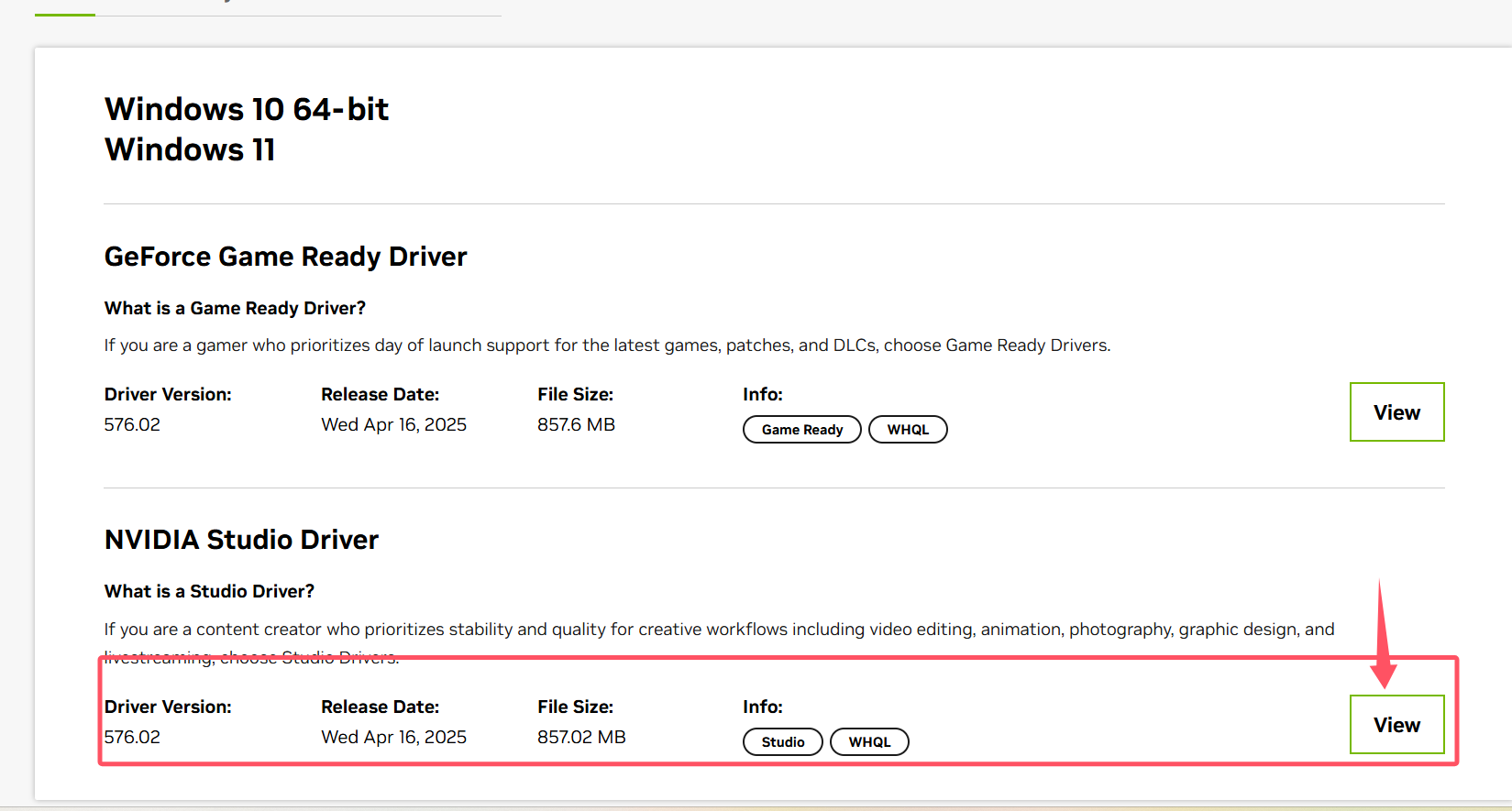

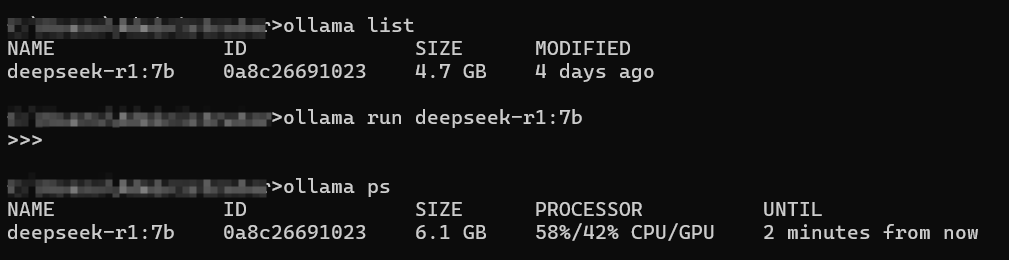

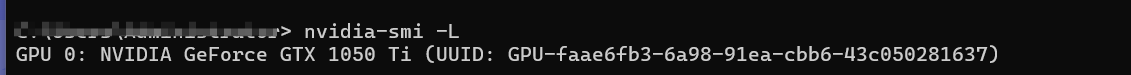

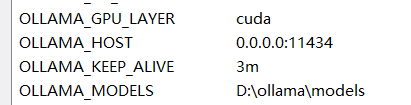

Loading... # ollama模型运行不跑GPU问题在线 Windows 原生安装的 Ollama **无法使用 GPU** 这是官方限制,目前 Windows 下的 Ollama 是通过 **WSL 虚拟机运行的** ,而 GPU 加速只在 **WSL 内部** 配置好后才能使用。  如果通过windows安装的ollama运行大模型时都是用的CPU那么你需要进行一下操作 ## 1、先查看你的显卡型号 在windows下的cmd中运行一下命令 ``` wmic path win32_VideoController get name ``` 结果如下  **这意味着** * 你**可以使用 CUDA 加速大模型推理** * Ollama(或其他模型框架) **只要在 WSL 中运行并配置好 NVIDIA 驱动** ,就能使用你的显卡 * **GTX 1050 Ti 虽然是老卡** ,但跑 7B 模型仍然没问题(比如 LLaMA3、Mistral 7B) 如果你查到没有 NVIDIA GPU,而是 **Intel 或 AMD 显卡** ,那 Ollama 目前是不支持 GPU 加速的,只能使用 CPU ## 2、官方网站下载对应的适用于WSL的GPU的驱动 [官方网站](https://developer.nvidia.com/cuda/wsl)  选择你显卡对应的驱动,根据我上面命令得到的结果,选择如下:  ## 适合 GTX 1050 Ti 的驱动版本 > 推荐安装: > > **NVIDIA Game Ready Driver / Studio Driver(支持 CUDA)**  如果不知道安装那个版本,问ai 下载安装后需要需要**重启电脑** 最后的结果就是成功  ## (选)配置环境变量 还有一些配置问题,不确定是不是主要问题,在解决的时候有修改,如果不成功可以把配置加上试试 1、找到系统环境变量编辑器 2、修改系统环境变量 如果需要指定特定的 GPU,可以添加以下环境变量,获取GPU的UUId ``` nvidia-smi -L ```   3、其他配置如下  **Ollama模型设置到D盘** ``` 变量名:OLLAMA_MODELS 变量值:D:\ollama\models ``` **让Ollama使用GPU** Ollama安装好后,为了让推理跑在GPU上,可以按照如下步骤 设置环境变量: ``` 变量名:OLLAMA_GPU_LAYER 变量值:cuda ``` **GPU释放** ``` 变量名:OLLAMA_KEEP_ALIVE 变量值:3m,默认是5m,降低GPU占用 ``` 最后修改:2025 年 04 月 17 日 © 允许规范转载 打赏 赞赏作者 支付宝微信 赞 如果觉得我的文章对你有用,请随意赞赏